حتى "بوكيمون" لم يسلم من الجدل حول تقييمات الذكاء الاصطناعي!

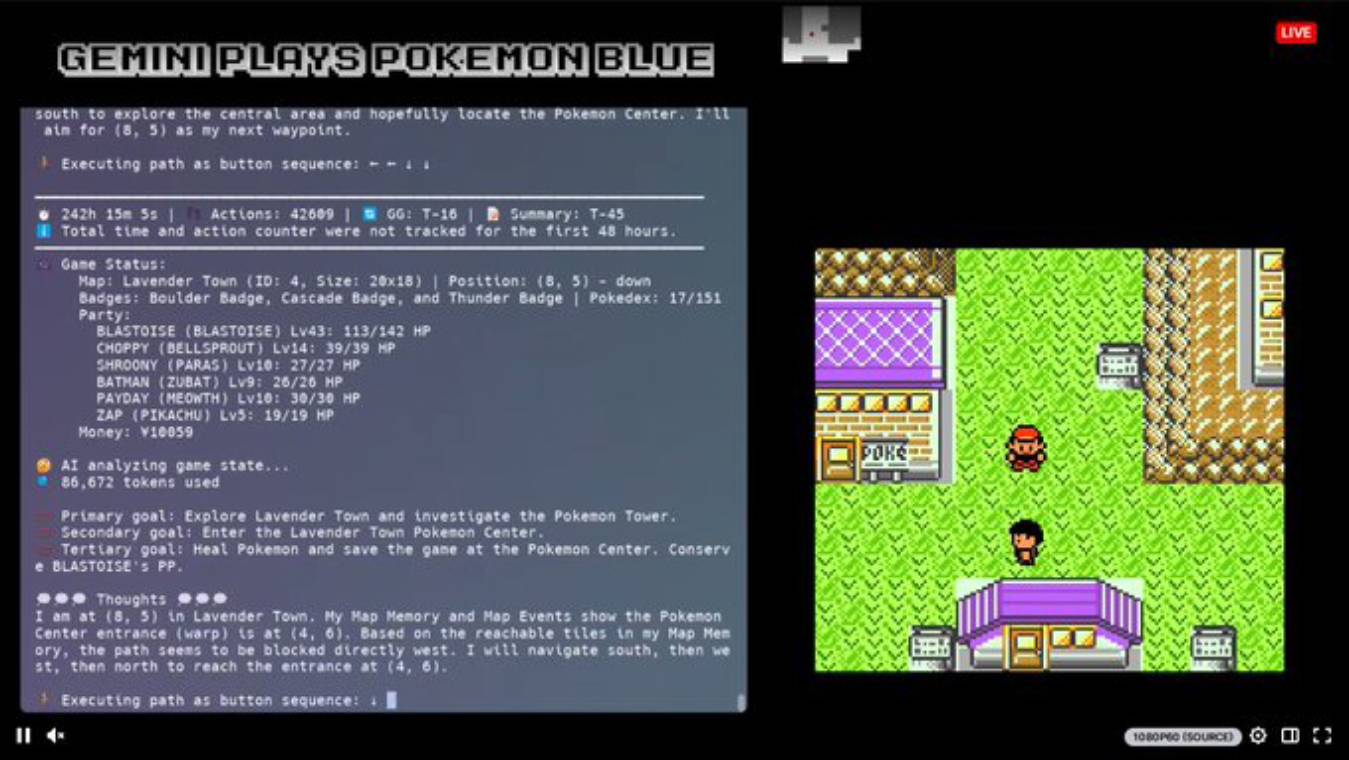

في الأسبوع الماضي، انتشر منشور على منصة X بشكل واسع، زاعمًا أن نموذج Gemini الجديد من شركة Google تفوّق على النموذج الأبرز من شركة Anthropic والمعروف باسم Claude، في سلسلة ألعاب بوكيمون الأصلية. ووفقًا للمنشور، فإن Gemini وصل إلى منطقة "Lavender Town" في بث مباشر على منصة Twitch، بينما ظل Claude عالقًا عند "Mount Moon" منذ أواخر فبراير.

لكن ما لم يذكره المنشور هو أن Gemini كان يتمتع بميزة تقنية.

كما أشار مستخدمو Reddit، فإن المطوّر الذي يشغّل بث Gemini قام ببناء خريطة مصغّرة مخصصة تساعد النموذج على التعرف على "المربعات" داخل اللعبة، مثل الأشجار القابلة للقطع، مما يقلل الحاجة إلى تحليل لقطات الشاشة قبل اتخاذ قرارات اللعب.

صحيح أن لعبة بوكيمون ليست معيارًا جادًا تمامًا في تقييم أداء نماذج الذكاء الاصطناعي، لكن القصة تكشف مثالًا واضحًا على كيف يمكن لاختلاف طرق تنفيذ الاختبارات أن يؤثر على النتائج بشكل كبير.

على سبيل المثال، ذكرت شركة Anthropic نتيجتين مختلفتين لنموذجها الأخير Claude 3.7 Sonnet في اختبار يسمى SWE-bench Verified، والذي يُستخدم لتقييم قدرات النماذج في البرمجة. النموذج حقق 62.3٪ دقة في الوضع العادي، بينما ارتفعت النتيجة إلى 70.3٪ عند استخدام "هيكل مخصص" قامت Anthropic بتطويره داخليًا.

أما شركة Meta، فقد قامت مؤخرًا بضبط نسخة من نموذجها الجديد Llama 4 Maverick لتحقق أداءً عاليًا على اختبار معين هو LM Arena، بينما النسخة الأصلية (دون تعديل) من نفس النموذج قدمت أداءً أضعف بشكل ملحوظ على نفس المعيار.

وفي ظل حقيقة أن اختبارات الذكاء الاصطناعي – بما فيها بوكيمون – ليست أدوات مثالية للتقييم من الأساس، فإن استخدام أدوات تنفيذ مخصصة وغير معيارية قد يزيد من تشويش المشهد ويجعل مقارنة النماذج أكثر تعقيدًا في المستقبل.

بمعنى آخر، من غير المرجّح أن تصبح مقارنة النماذج أسهل مع استمرار طرح الإصدارات الجديدة.